Automattic, das Unternehmen hinter WordPress und Tumblr, ist in Gesprächen über die Monetarisierung von Benutzerinhalten durch den Verkauf seiner Daten an Unternehmen für künstliche Intelligenz, darunter MidJourney und OpenAI. Diese Daten der Blogging-Plattformen Tumblr und WordPress.com werden zum Trainieren der KI-Modelle verwendet.

Während die Einzelheiten der Transaktion noch unklar sind, haben die Nachrichten bei den Nutzern Bedenken hinsichtlich eines möglichen Missbrauchs ihrer privaten Inhalte auf den beiden Blogging-Plattformen geweckt. 404 Media weist außerdem darauf hin, dass es zu internen Konflikten innerhalb von Automattic kam, weil die gesammelten Inhalte private Daten enthielten, die nicht dazu gedacht waren, im Unternehmen gespeichert zu werden.

Als Reaktion auf die Gegenreaktion wird Automattic eine neue Funktion einführen, die es Benutzern ermöglicht, die Weitergabe ihrer Daten für KI-Schulungen abzulehnen. In einem Blogbeitrag bekräftigt das Unternehmen sein Engagement, Tumblr- und Wordpress-Benutzern mehr Kontrolle über ihre Inhalte zu geben. Erwähnt die Veröffentlichung einer Einstellung für “um die Erkundung durch KI-Unternehmen zu verhindern”, und erklärt, dass führende KI-Explorationsplattformen standardmäßig blockiert sind.

Das Problem der Nutzung von Inhalten aus Blogs durch Unternehmen, die KI-Modelle entwickeln, beschränkt sich nicht nur auf die von der Firma Automattic verwalteten Plattformen. Sowohl OpenAI als auch Google verwenden Crawler-Bots, die Informationen von allen Websites sammeln, um ihre KI-Modelle zu trainieren. Der Prozess ähnelt der Datenerfassung durch Suchmaschinen.

Wie können Sie verhindern, dass OpenAI und Gemini (Bard) Daten aus Ihrem Blog übernehmen?

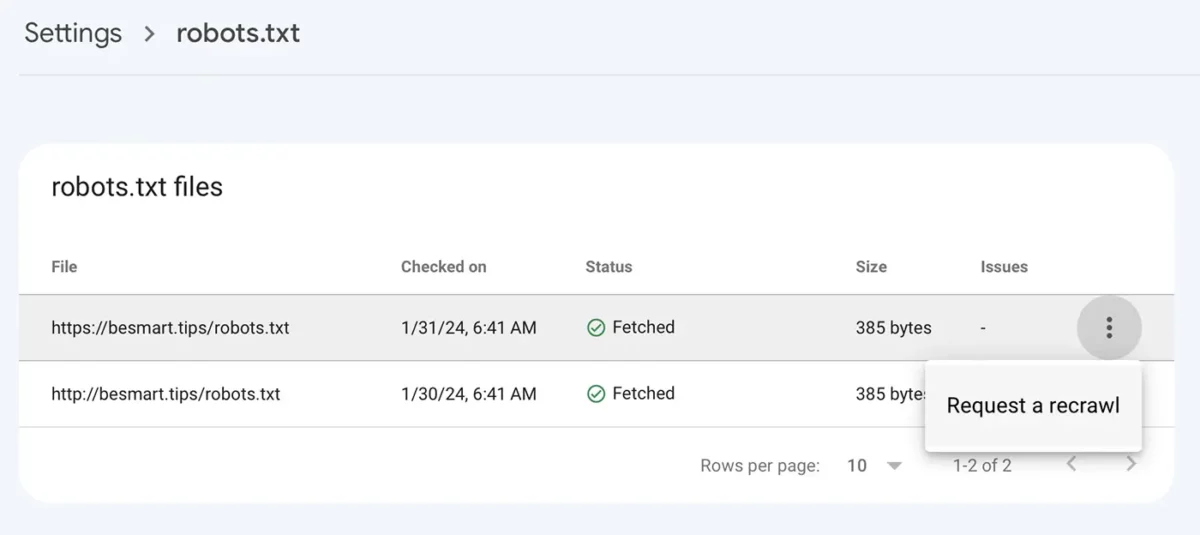

Wenn Sie Inhaber eines Blogs oder einer Website sind und nicht möchten, dass die Daten daraus zum Trainieren der künstlichen Intelligenzmodelle OpenAI und Gemini verwendet werden, können Sie den Zugriff von Robotern (Crawlern) auf die Inhalte blockieren. Diese Einschränkung kann über die Datei eingestellt werden robots.txt.

OpenAI Crawlers

User-agent: GPTBot

Disallow: /Gemini Crawlers

User-agent: Google-Extended

Disallow: /Nachdem Sie die robots.txt-Datei mit den neuen Zeilen gespeichert haben, rufen Sie die Google Console auf, um Folgendes zu tun: Settings > robots.txt > Klicken Sie auf das Menü mit den drei Punkten, klicken Sie “Request a recrawl“.

Verwandt: GPT-5 und der neue von OpenAI entwickelte GPTBot-Webcrawler

Für Tumblr- und Wordpress-Benutzer kann der Zugriff auf den Datenabruf aus Blogs durch OpenAI oder andere Unternehmen, die künstliche Intelligenz entwickeln, mithilfe der von der Firma Automattic zur Verfügung gestellten Tools blockiert werden.

Tumblr und Wordpress werden Benutzerdaten an OpenAI verkaufen

Was ist neu

Um Stealth

Technologiebegeistert schreibe ich seit 2006 gerne auf StealthSettings.com. Ich habe umfangreiche Erfahrungen mit Betriebssystemen wie macOS, Windows und Linux sowie mit Programmiersprachen, Blogging-Plattformen (WordPress) und Online-Shops (WooCommerce, Magento, PrestaShop).

Alle Beiträge von Stealth anzeigenVielleicht interessieren Sie sich auch für...