רוב הזמן, כאשר אתה צריך לחסום גישה SeekportBot או אחרים crawl bots עם אתר, הסיבות לכך פשוטות. עכביש האינטרנט מבצע יותר מדי גישה בפרק זמן קצר ומבקש את המשאבים של שרת האינטרנט, או שהוא מגיע ממנוע חיפוש שבו אינך רוצה שהאתר שלך יתווסף לאינדקס.

תוֹכֶן

זה מאוד מועיל לאתר בו מבקרים בוטים לסריקה. עכבישי האינטרנט הללו נועדו לחקור, לעבד ולהוסיף לאינדקס את התוכן של דפי אינטרנט במנועי חיפוש. גוגל ובינג משתמשות בווטי סריקה כאלה. עם זאת, ישנם גם מנועי חיפוש המשתמשים ברובוטים כדי לאסוף נתונים מדפי אינטרנט. Seekport הוא אחד ממנועי החיפוש הללו, המשתמש בסורק SeekportBot כדי לאינדקס דפי אינטרנט. למרבה הצער, לפעמים הוא משתמש בו בצורה מוגזמת ויוצר תנועה מיותרת.

מה זה SeekportBot?

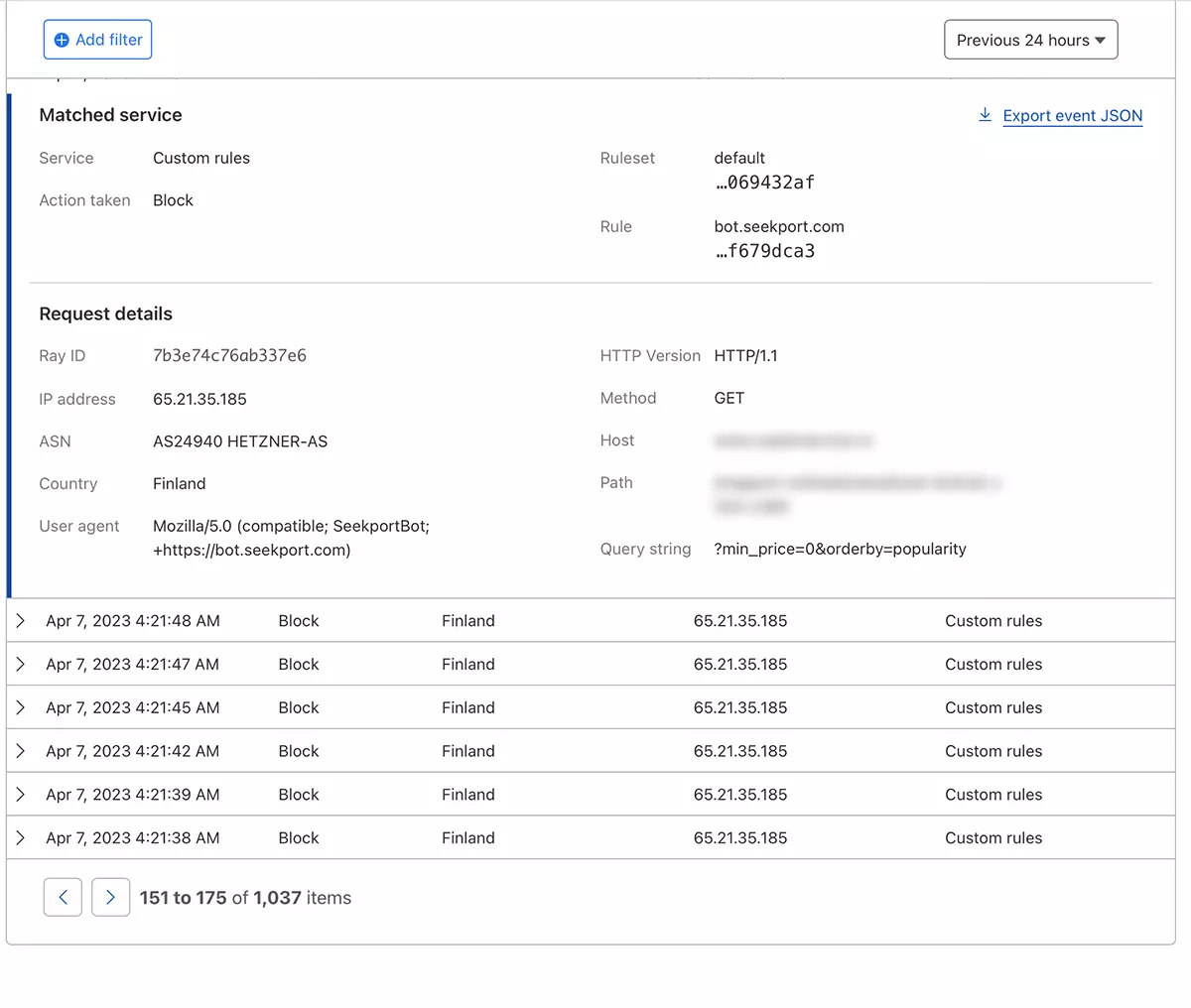

SeekportBot זה א web crawler שפותחה על ידי החברה Seekport, שבסיסה בגרמניה (אך משתמש בכתובות IP ממספר מדינות, כולל פינלנד). בוט זה משמש לסריקה ואינדקס של אתרים כך שניתן יהיה להציגם בתוצאות של מנוע החיפוש. Seekport. מנוע חיפוש לא פונקציונלי, למיטב ידיעתי. לפחות, זה לא החזיר לי שום תוצאות עבור שום ביטוי מפתח.

SeekportBot לְהִשְׁתַמֵשׁ user agent:

"Mozilla/5.0 (compatible; SeekportBot; +https://bot.seekport.com)"איך חוסמים את הגישה של SeekPortbot או בוטים זחילים אחרים לאתר

אם הגעתם למסקנה שעכביש האינטרנט הזה או אחר, אין צורך לסרוק את כל האתר שלכם ולעשות תנועה מיותרת לשרת האינטרנט, יש לכם מספר שיטות בהן תוכלו לחסום את הגישה שלהם.

חומת אש ברמת שרת האינטרנט

הם יישומי חומת אש open-source אשר ניתן להתקין על מערכות הפעלה לינוקס וניתן להגדיר אותו לחסום תעבורה על סמך מספר קריטריונים. כתובת IP, מיקום, יציאות, פרוטוקולים או סוכן משתמש.

APF (Advanced Policy Firewall) היא תוכנה כזו שדרכה ניתן לחסום בוטים לא רצויים, ברמת השרת.

מכיוון ש-SeekportBot ועכבישי אינטרנט אחרים משתמשים במספר בלוקים של כתובות IP, כלל החסימה היעיל ביותר מבוסס על “user agent“. אז, אם אתה רוצה לחסום גישה SeekportBot בעזרה APF, כל מה שאתה צריך לעשות הוא להתחבר לשרת האינטרנט באמצעות SSH, והוסיפו את כלל הסינון בקובץ התצורה.

1. פתח את קובץ התצורה עם nano (או מוציא לאור אחר).

sudo nano /etc/apf/conf.apf2. חפשו את השורה שמתחילה בה “IG_TCP_CPORTS” והוסף את סוכן המשתמש שברצונך לחסום בסוף שורה זו, ואחריו פסיק. לדוגמה, אם אתה רוצה לחסום user agent “SeekportBot“, השורה צריכה להיראות כך:

IG_TCP_CPORTS="80,443,22" && IG_TCP_CPORTS="$IG_TCP_CPORTS,SeekportBot"3. שמור את הקובץ והפעל מחדש את שירות APF.

sudo systemctl restart apf.serviceגִישָׁה “SeekportBot” ייחסם.

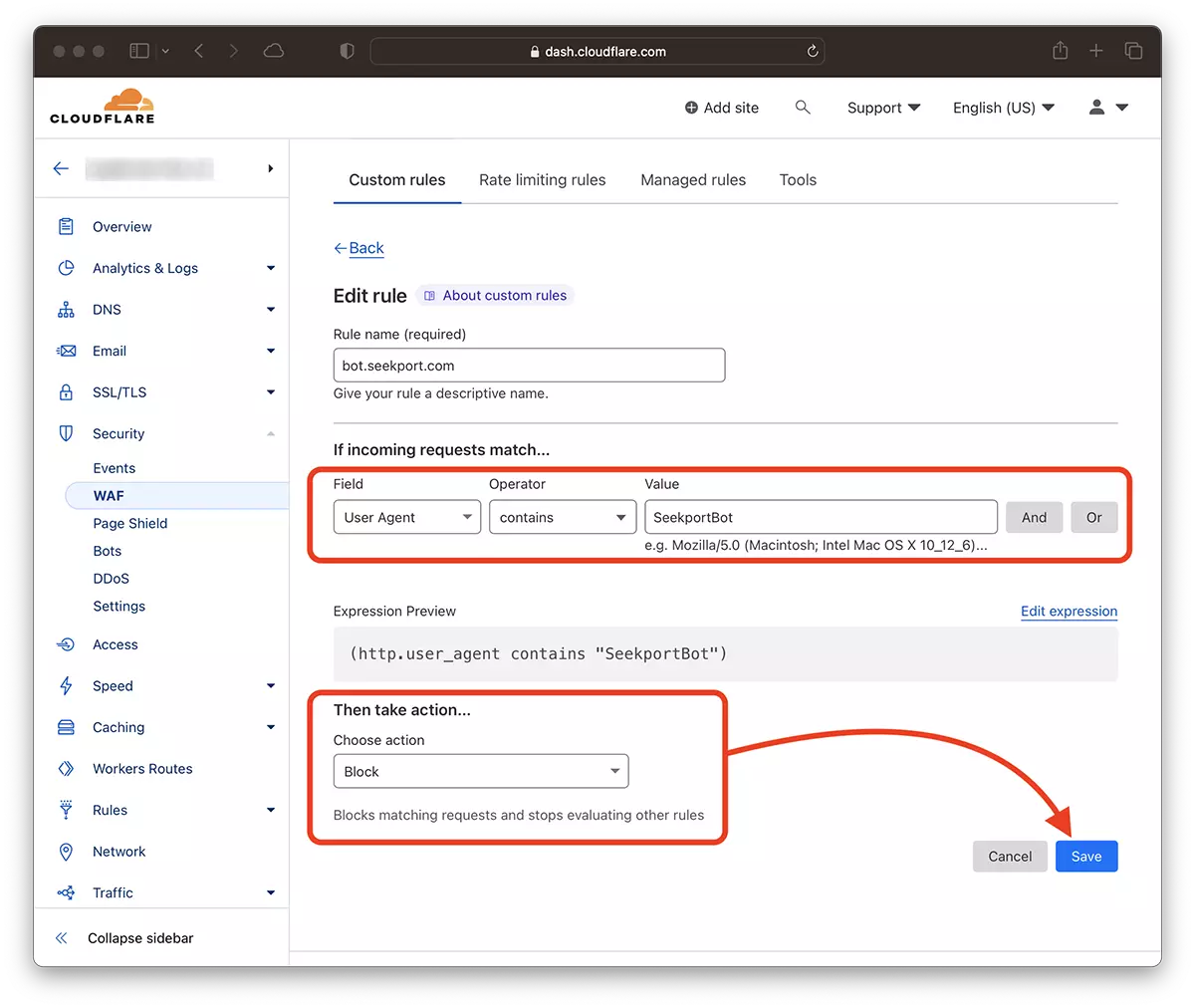

סִנוּן web crawls בעזרת Cloudflare – חסום גישה ל-SeekportBot

בעזרת Cloudflare, זו נראית לי השיטה הבטוחה והנוחה ביותר באמצעותה ניתן להגביל את הגישה של כמה בוטים לאתר בדרכים שונות. השיטה בה השתמשתי גם במקרה SeekportBot לסנן תנועה לחנות מקוונת.

בהנחה שכבר הוספת את האתר ל-Cloudflare ושירותי ה-DNS מופעלים (כלומר, התעבורה לאתר עוברת דרך Cloudflare), בצע את השלבים הבאים:

1. פתח את חשבון Clouflar שלך ועבור לאתר שאליו ברצונך להגביל את הגישה.

2. עבור אל: Security → WAF ולהוסיף כלל חדש. Create ruleו

3. Alegi un nume pentru noua regula, Field: User Agent – Operator: Contains – Value: SeekportBot (או שם בוט אחר) – Choose action: Block – Deployו

תוך שניות ספורות, הכלל החדש WAF (Web Application Firewall) זה מתחיל להשפיע.

בתיאוריה, ניתן לקבוע את התדירות שבה עכביש רשת ניגש לאתר robots.txt, אבל… זה רק בתיאוריה.

User-agent: SeekportBot

Crawl-delay: 4סורקי אינטרנט רבים (חוץ מבינג וגוגל) אינם מכבדים כללים אלו.

לסיכום, אם אתה מזהה סריקת אינטרנט שנכנסת יתר על המידה לאתר שלך, עדיף לחסום את הגישה הכוללת שלה. כמובן, אם הבוט הזה הוא לא ממנוע חיפוש שבו אתה מעוניין להיות נוכח.