Hvordan blokerer du adgangen til SeekportBot eller andre gennemsøgningsbots til et websted

Hvordan blokerer du adgangen til SeekportBot eller andre gennemsøgningsbots til et websted

Det meste af tiden, når du har brug for at blokere adgangen SeekportBot eller til andre crawl bots På et websted er grundene enkle. Web Spider får for mange adgang på en kort periode og anmoder om serverwebressourcer eller kommer fra en søgemaskine, hvor du ikke ønsker, at dit websted skal indekseres.

tilfreds

Det er meget fordelagtigt for et websted har besøgt af gennemsøgningsbots. Disse webspider er designet til at udforske, behandle og indeksere indholdet af websider i søgemaskiner. Google og Bing bruger sådanne crawl bots. Men der er også søgemaskiner, der bruger robotter til indsamling af data fra websider. Seekport Det er en af disse søgemaskiner, der bruger SeekportBot Crawler til at indeksere websider. Desværre bruger den undertiden det på en overdreven måde og gør ubrugelig trafik.

Hvad er søgportbot?

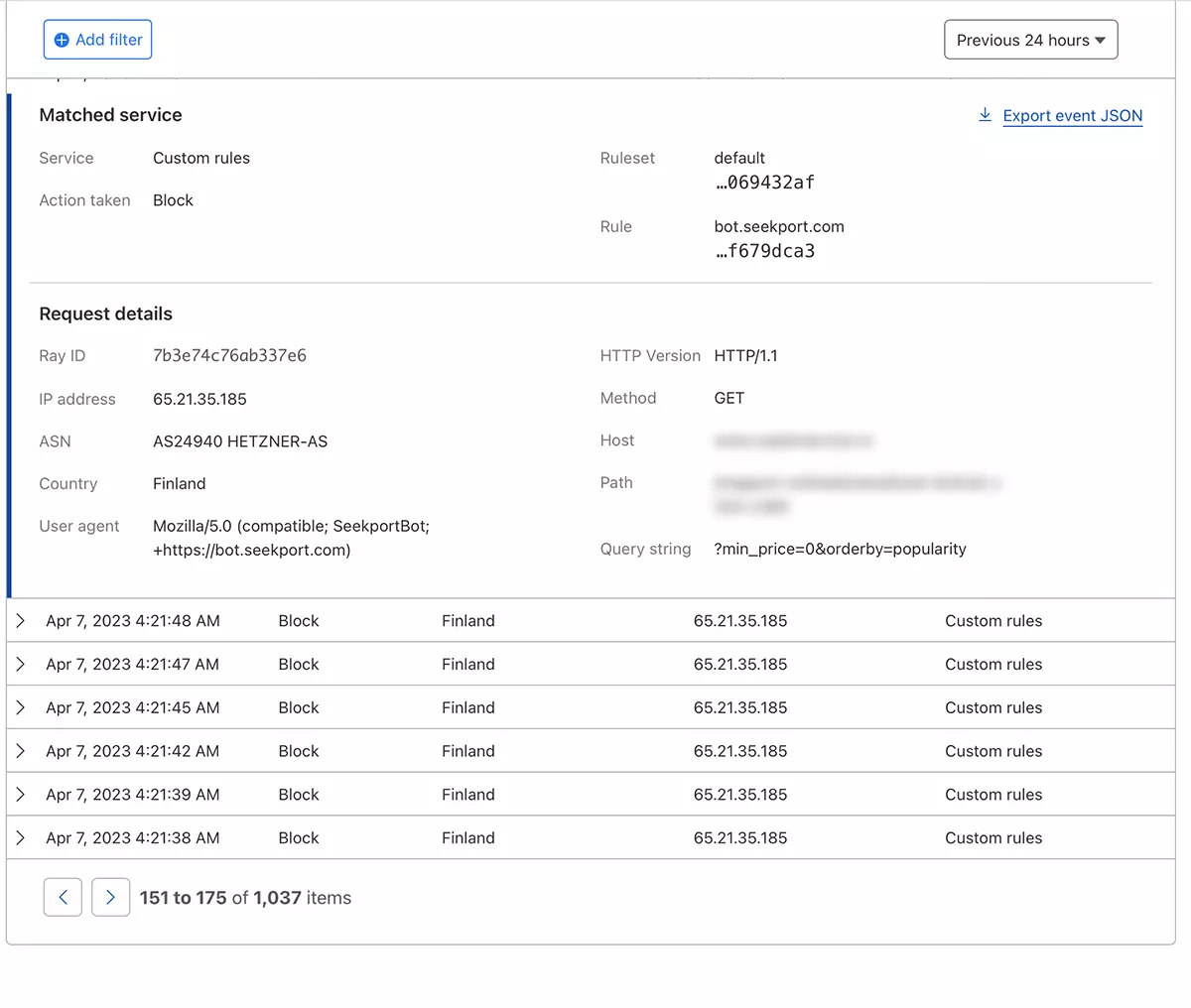

SeekportBot Det er en web crawler udviklet af virksomheden Seekport, som er baseret i Tyskland (men bruger IP'er fra flere lande, herunder Finland). Denne bot bruges til at udforske og indeksere websteder, så de kan vises i søgeresultater på søgemaskinen Seekport. En ikke -funktionel søgemaskine, så vidt jeg er klar over. I det mindste returnerede jeg ikke resultater for nogen nøglefrase.

SeekportBot BRUGE user agent:

"Mozilla/5.0 (compatible; SeekportBot; +https://bot.seekport.com)"Hvordan blokerer du adgangen til SeekportBot eller andre gennemsøgningsbots til et websted

Hvis du er kommet til den konklusion, at denne edderkopweb eller en anden er det ikke nødvendigt at scanne hele dit websted og lave en ubrugelig trafik på webserveren, har du flere måder at blokere deres adgang på.

Firewall serverwebniveauet

Er firewall gælder open-source som kan installeres på Linux -operativsystemer og kan konfigureres til at blokere trafik på flere kriterier. IP -adresse, placering, porte, protokoller eller brugeragent.

APF (Advanced Policy Firewall) Det er sådan en software, gennem hvilken du kan blokere uønskede buler på serverniveau.

Fordi SeekportBot og andre webspiders bruger flere IP -blokke, er den mest effektive låsegel baseret på “user agent“. Asar, hvis du vil blokere adgangen SeekportBot med hjælp APF, Alt hvad du skal gøre er at oprette forbindelse til webserveren af SSH, og tilføj filtreringsreglen til konfigurationsfilen.

1. Åbn konfigurationsfilen med nano (eller anden redaktør).

sudo nano /etc/apf/conf.apf2. kig efter den linje, der starter med “IG_TCP_CPORTS” Og tilføj den brugeragent, du vil blokere i slutningen af denne linje, efterfulgt af et komma. For eksempel, hvis du vil blokere user agent “SeekportBot“, linjen skal se sådan ud:

IG_TCP_CPORTS="80,443,22" && IG_TCP_CPORTS="$IG_TCP_CPORTS,SeekportBot"3. Gem filen og genstart APF -tjenesten.

sudo systemctl restart apf.serviceadgang “Søgportbot” vil blive blokeret.

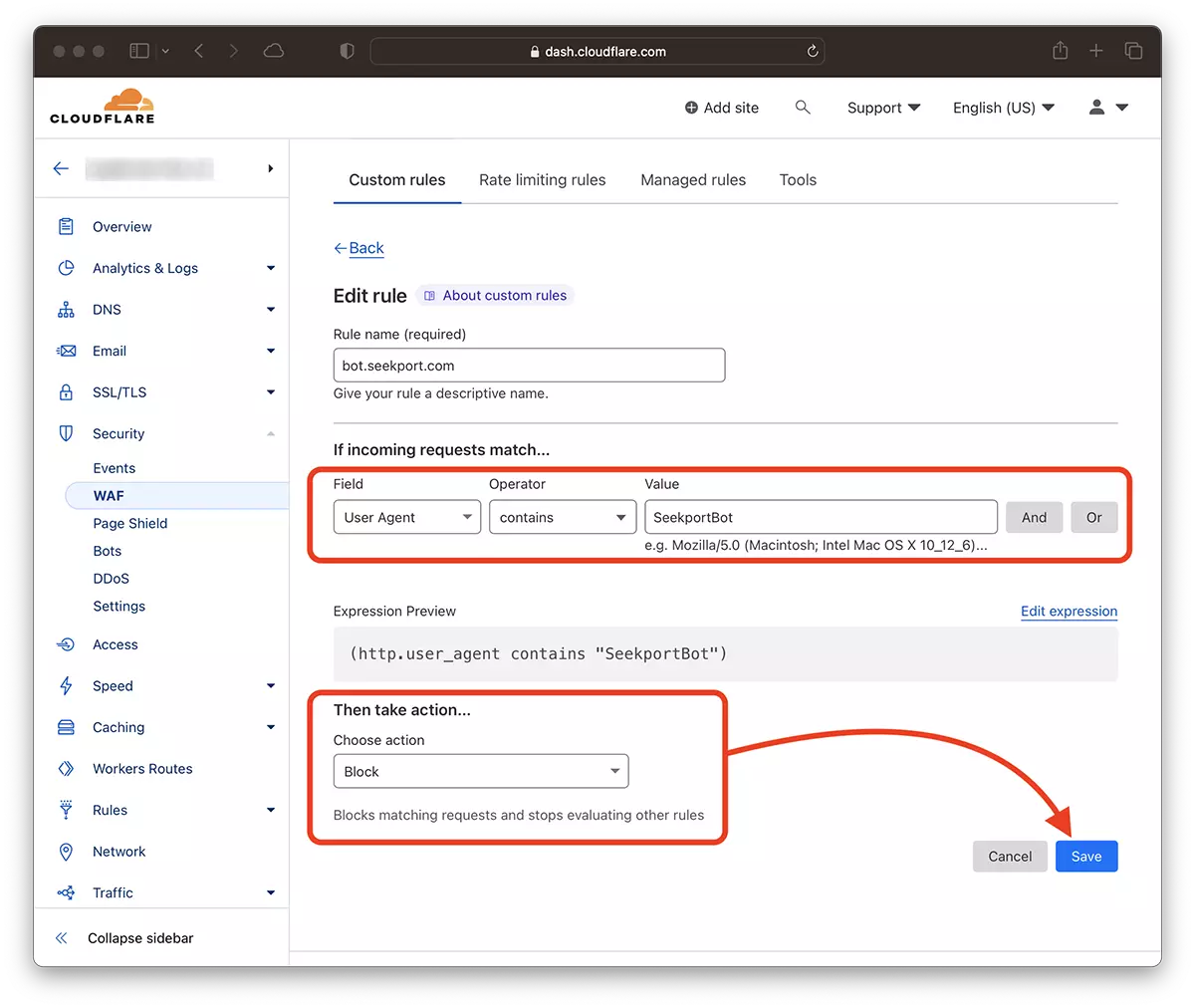

Filtrering web crawls Ved hjælp af Cloudflare – Bloker din søgning af portbot

Ved hjælp af Cloudfre ser det ud til for mig den sikreste og mest praktiske metode, som du på forskellige måder kan begrænse adgang til nogle bits til et websted. Den metode, jeg har brugt i tilfælde af SeekportBot at filtrere trafik til en online butik.

Hvis du antager, at du allerede har tilføjet webstedet til CloudFlore, og DNS -tjenesterne er aktiveret (dvs. trafikken til webstedet er udført af sky), følg nedenstående trin:

1. Åbn Clouflare -kontoen og gå til det websted, som du vil begrænse adgangen til.

2. gå til: Security → WAF og tilføj en ny regel. Create rule.

3. Vælg et navn til den nye regel, Field: User Agent – Operator: Contains – Value: SeekportBot (eller andet botnavn) – Choose action: Block – Deploy.

På bare få sekunder den nye regel WAF (Web Application Firewall) Han begynder at gøre sin virkning.

I teorien kan den hyppighed, hvormed en edderkopweb for at få adgang til et websted, indstilles fra robots.txtdog… Det er kun i teorien.

User-agent: SeekportBot

Crawl-delay: 4Mange webcrawlere (bortset fra Bing og Google) følger ikke disse regler.

Afslutningsvis, hvis du identificerer et gennemsøgningsweb, der overdrevent får adgang til dit websted, er det bedst at blokere dets samlede adgang. Selvfølgelig, hvis denne bot ikke er fra en søgemaskine, hvor du er interesseret i at være til stede.

Hvordan blokerer du adgangen til SeekportBot eller andre gennemsøgningsbots til et websted

Hvad er nyt

Om Stealth

Passioneret omkring teknologi, skriver jeg med glæde på StealthSettings.com siden 2006. Jeg har stor erfaring med operativsystemer: macOS, Windows og Linux, samt med programmeringssprog og bloggingplatforme (WordPress) og til webshops (WooCommerce, Magento, PrestaShop).

Se alle indlæg af StealthDu kan også være interesseret i...