Cum blochezi accesul SeekportBot sau altor crawl bots la un website

De cele mai multe ori, atunci cand ai nevoie sa blochezi accesul SeekportBot sau altor crawl bots la un website, motivele sunt simple. Spider-ul web face prea multe accesari intr-o perioada scurta de timp si solicita resursele web serverului, fie provine de la un motor de cautare in care nu doresti ca website-ul tau sa fie indexat.

Cuprins

Este foarte benefic pentru un website sa vizitat de crawl bots. Acesti spideri web sunt conceputi pentru a explora, procesa si indexa continutul paginlor web in motoare de cautare. Google si Bing folosesc astfel de crawl bots. Sunt insa si motoare de cautare care folosesc roboti pentru culegerea de date de pe pagini web. Seekport este unul dintre aceste motoare de cautare, care ca foloseste crawler-ul SeekportBot pentru indexarea paginilor web. Din pacate, il foloseste uneori intr-un mod excesiv si face trafic inutil.

Ce este SeekportBot?

SeekportBot este un web crawler dezvoltat de compania Seekport, care are sediul in Germania (dar foloseste IP-uri din mai multe tari, printre care si din Finlanda). Acest bot este folosit pentru a explora si indexa site-urile web, astfel incat acestea sa poata fi afisate in rezultatele cautarii pe motorul de cautare Seekport. Un motor de cautare nefunctional, din cate imi dau seama. Cel putin, mie nu mi-a returnat rezultate pentru nicio fraza cheie.

SeekportBot foloseste user agent:

"Mozilla/5.0 (compatible; SeekportBot; +https://bot.seekport.com)"Cum blochezi accesul SeekportBot sau altor crawl bots la un website

Daca ai ajuns la concluzia ca acest spider web sau un altul, nu este necesar sa iti scaneze tot website-ul si sa faca un trafic inutil de serverul web, ai mai multe metode prin care le poti bloca accesul.

Firewall la nivel de server web

Sunt aplciatii firewall open-source care pot fi instalate pe sistemele de operare Linux si pot fi configurate sa blocheze traficul pe mai multe criterii. Adresa IP, locatie, porturi, protocoale sau user agent.

APF (Advanced Policy Firewall) este un astfel de software prin care poti bloca botii nedoriti, la nivel de server.

Pentru ca SeekportBot si alti web spideri folosesc mai multe blocuri de IP-uri, cea mai eficienta regula de blocare, este pe baza „user agent„. Asdar, daca doriti sa blocati accesul SeekportBot cu ajutorul APF, tot ce trebuie sa faceti, este sa va conectati la serverul web prin SSH, si sa adaugati regula de filtrare in fisierul de configurare.

1. Deschizi fisierul de configuratie cu nano (sau alt editor).

sudo nano /etc/apf/conf.apf2. Cauti linia care incepe cu „IG_TCP_CPORTS” si adaugi user agent-ul pe care doresti sa il blochezi la sfarsitul acestei linii, urmat de o virgula. De exemplu, daca doresti sa blochezi user agent „SeekportBot„, linia ar trebui sa arate astfel:

IG_TCP_CPORTS="80,443,22" && IG_TCP_CPORTS="$IG_TCP_CPORTS,SeekportBot"3. Salvezi fisierul si restartezi serviciul APF.

sudo systemctl restart apf.serviceAccesul „SeekportBot” va fi blocat.

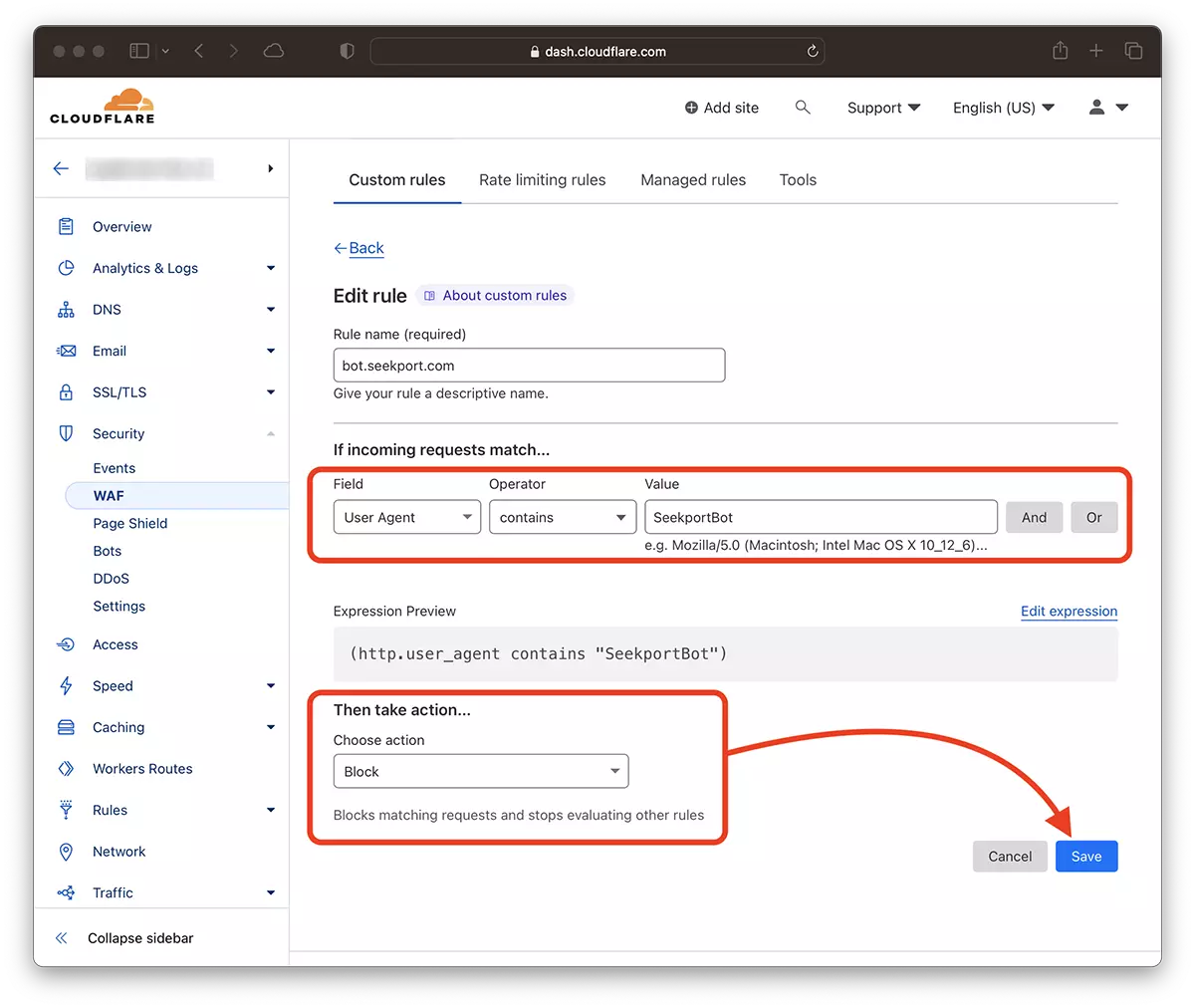

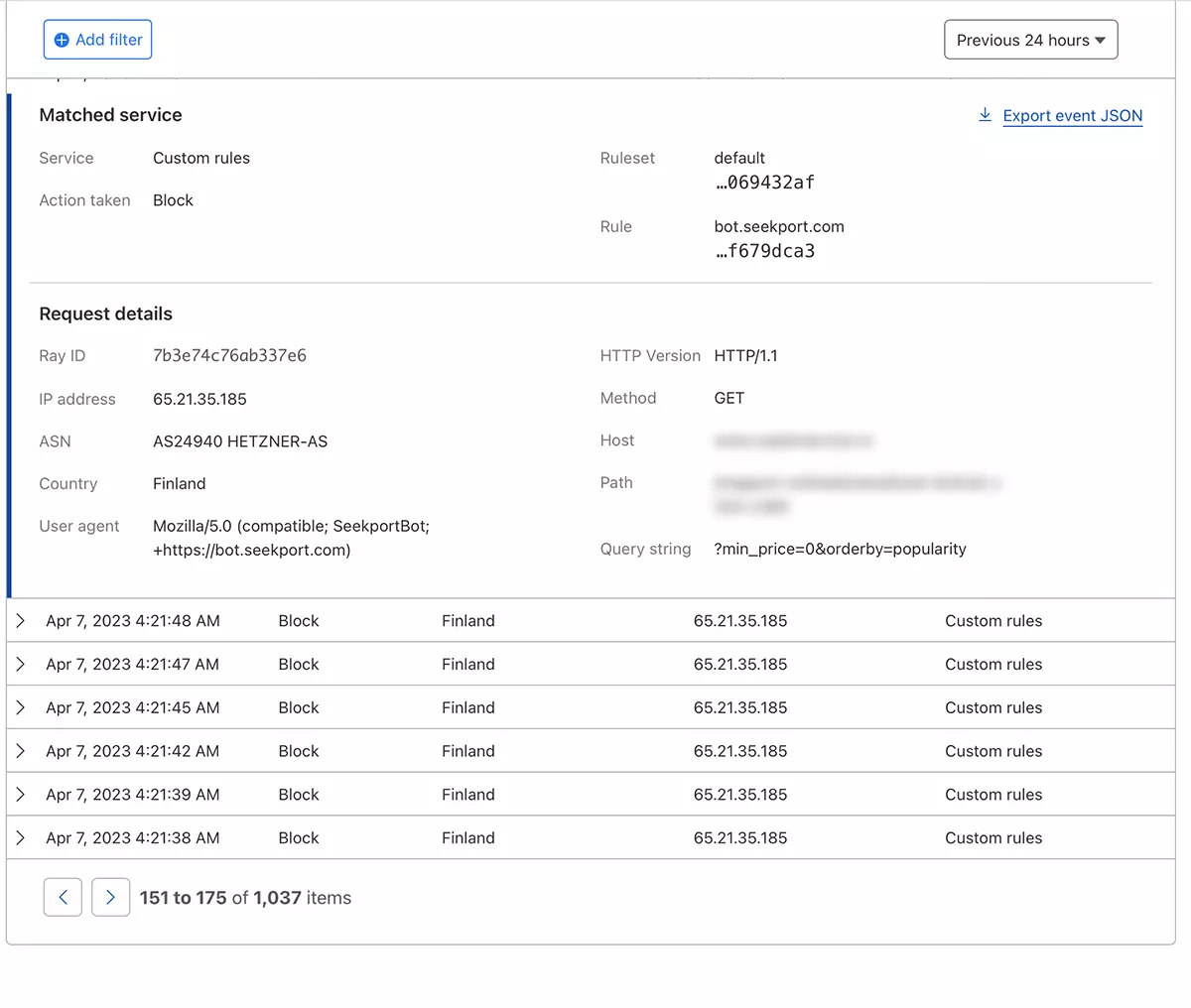

Filtrare web crawls cu ajutorul Cloudflare – Blochezi accesul SeekportBot

Cu ajutorul Cloudflare mi se pare cea mai sigura si cea mai la indemana metoda prin care poti limita in diverse moduri accesul unor boti la un site web. Metoda pe care de altfel am si folosit-o in cazul SeekportBot pentru a filtra traficul spre un magazin online.

Presupunand ca ai deja website-ul adaugat in Cloudflare si serviciile DNS sunt activate (adica traficul spre site se face prin Cloudflare), urmeaza pasii de mai jos:

1. Deschizi contul de Clouflare si mergi la website-ul pentru care vrei sa limitezi accesul.

2. Mergi la: Security → WAF si adauga o noua regula. Create rule.

3. Alegi un nume pentru noua regula, Field: User Agent – Operator: Contains – Value: SeekportBot (sau alt nume de bot) – Choose action: Block – Deploy.

In doar cateva secunde, noua regula WAF (Web Application Firewall) incepe sa-si faca efectul.

In teorie, frecventa prin care un spider web sa accese un site, poate fi setata din robots.txt, insa… este doar in teorie.

User-agent: SeekportBot

Crawl-delay: 4Foarte multi web crawlerii (in afara de Bing si Google) nu respecta aceste reguli.

In concluzie, daca identitifici un web crawl care iti acceseaza in mod excesiv site-ul, cel mai bine este sa-i blochezi accesul total. Desigur, daca acest bot nu este de la un motor de cautare in care te intereseaza sa fii prezent.

Cum blochezi accesul SeekportBot sau altor crawl bots la un website

What’s New

About Stealth

Pasionat de tehnologie, scriu cu plăcere pe StealthSettings.com începând cu anul 2006. Am o bogată experiență în sistemele de operare: macOS, Windows și Linux, dar și în limbaje de programare și platforme de blogging (WordPress) și pentru magazine online (WooCommerce, Magento, PrestaShop).

View all posts by StealthTe-ar putea interesa și...