Come si blocca l'accesso di SeekportBot o altri robot di gattoni su un sito Web

Come si blocca l'accesso di SeekportBot o altri robot di gattoni su un sito Web

Il più delle volte, quando è necessario bloccare l'accesso SeekportBot o agli altri crawl bots In un sito Web, i motivi sono semplici. Il ragno Web fa troppi accesso in un breve periodo di tempo e richiede le risorse Web del server o proviene da un motore di ricerca in cui non si desidera che il tuo sito Web venga indicizzato.

contenuto

È molto vantaggioso per un sito Web visitato da Crawl Bots. Queste spide Web sono progettate per esplorare, elaborare e indicizzare il contenuto delle pagine Web nei motori di ricerca. Google e Bing usano tali robot di scansione. Ma ci sono anche motori di ricerca che utilizzano robot per la raccolta di dati dalle pagine Web. Seekport È uno di questi motori di ricerca, che utilizza il crawler SeekPortBot per indicizzare le pagine Web. Sfortunatamente, a volte lo usa in modo eccessivo e fa un traffico inutile.

Qual è il SeekportBot?

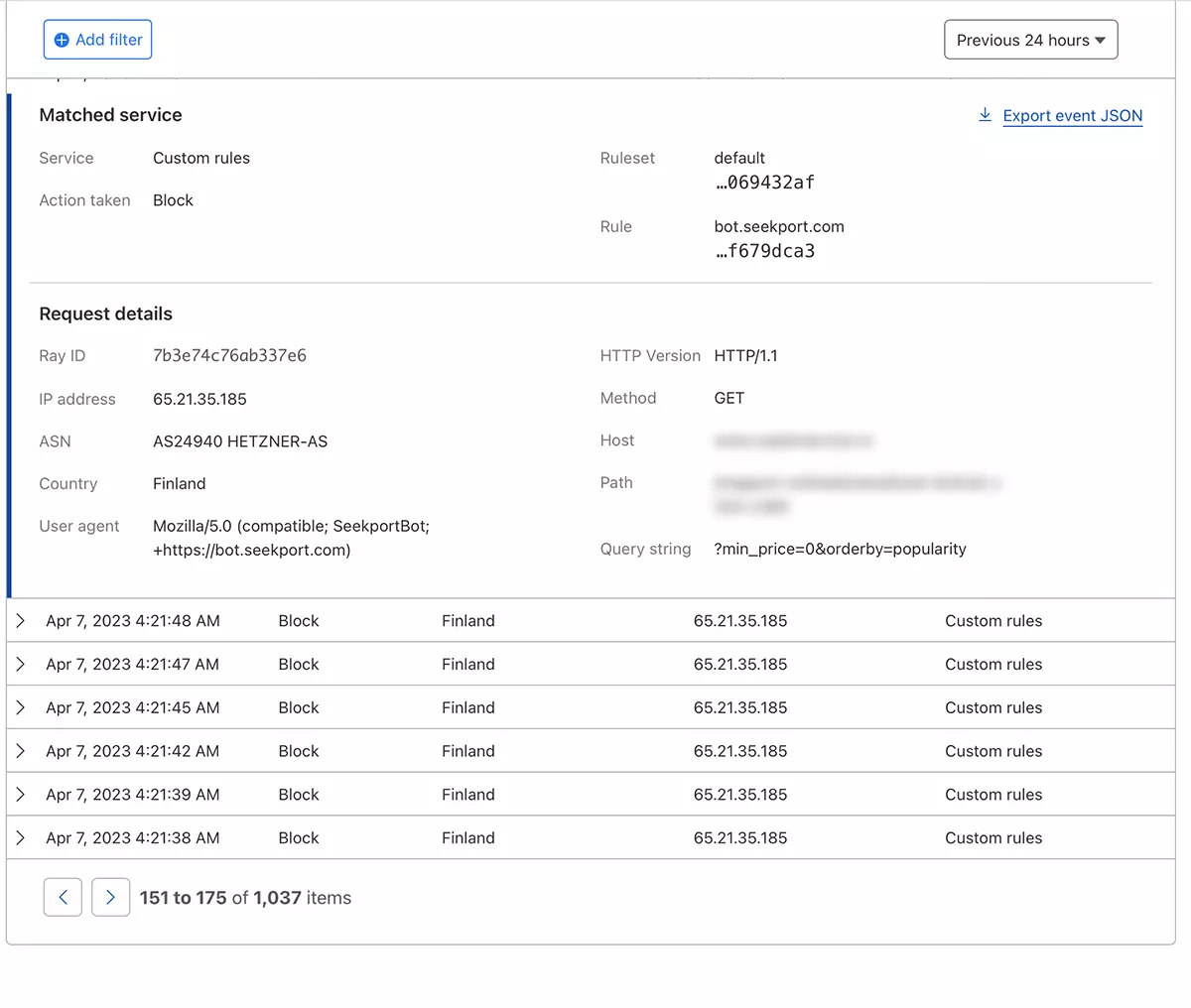

SeekportBot È un web crawler Sviluppato dall'azienda Seekport, che ha sede in Germania (ma utilizza IP di diversi paesi, tra cui la Finlandia). Questo bot viene utilizzato per esplorare e indicizzare i siti Web in modo che possano essere visualizzati nei risultati di ricerca sul motore di ricerca Seekport. Un motore di ricerca non funzionale, per quanto mi realizzo. Almeno, non ho reso i risultati per alcuna frase chiave.

SeekportBot UTILIZZO user agent:

"Mozilla/5.0 (compatible; SeekportBot; +https://bot.seekport.com)"Come si blocca l'accesso di SeekportBot o altri robot di gattoni su un sito Web

Se sei giunto alla conclusione che questo Web di Spider o un altro, non è necessario scansionare l'intero sito Web e fare un traffico inutile dal server Web, hai diversi modi per bloccare il loro accesso.

Firewall Il livello Web del server

Sono il firewall si applica open-source che può essere installato su sistemi operativi Linux e può essere configurato per bloccare il traffico su diversi criteri. Indirizzo IP, posizione, porte, protocolli o agente utente.

APF (Advanced Policy Firewall) È un tale software attraverso il quale è possibile bloccare i dossi indesiderati, a livello del server.

Poiché SeekportBot e altri ragni Web utilizzano diversi blocchi IP, la regola di blocco più efficiente si basa su “user agent“. Asar, se si desidera bloccare l'accesso SeekportBot con l'aiuto APF, tutto quello che devi fare è connetterti al server web SSHe aggiungere la regola di filtraggio al file di configurazione.

1. Apri il file di configurazione con nano (o altro editore).

sudo nano /etc/apf/conf.apf2. Cerca la linea che inizia con “IG_TCP_CPORTS” E aggiungi l'agente utente che si desidera bloccare alla fine di questa riga, seguito da una virgola. Ad esempio, se vuoi bloccare user agent “SeekportBot“, Line dovrebbe apparire così:

IG_TCP_CPORTS="80,443,22" && IG_TCP_CPORTS="$IG_TCP_CPORTS,SeekportBot"3. Salva il file e riavvia il servizio APF.

sudo systemctl restart apf.serviceaccesso “Seekportbot” sarà bloccato.

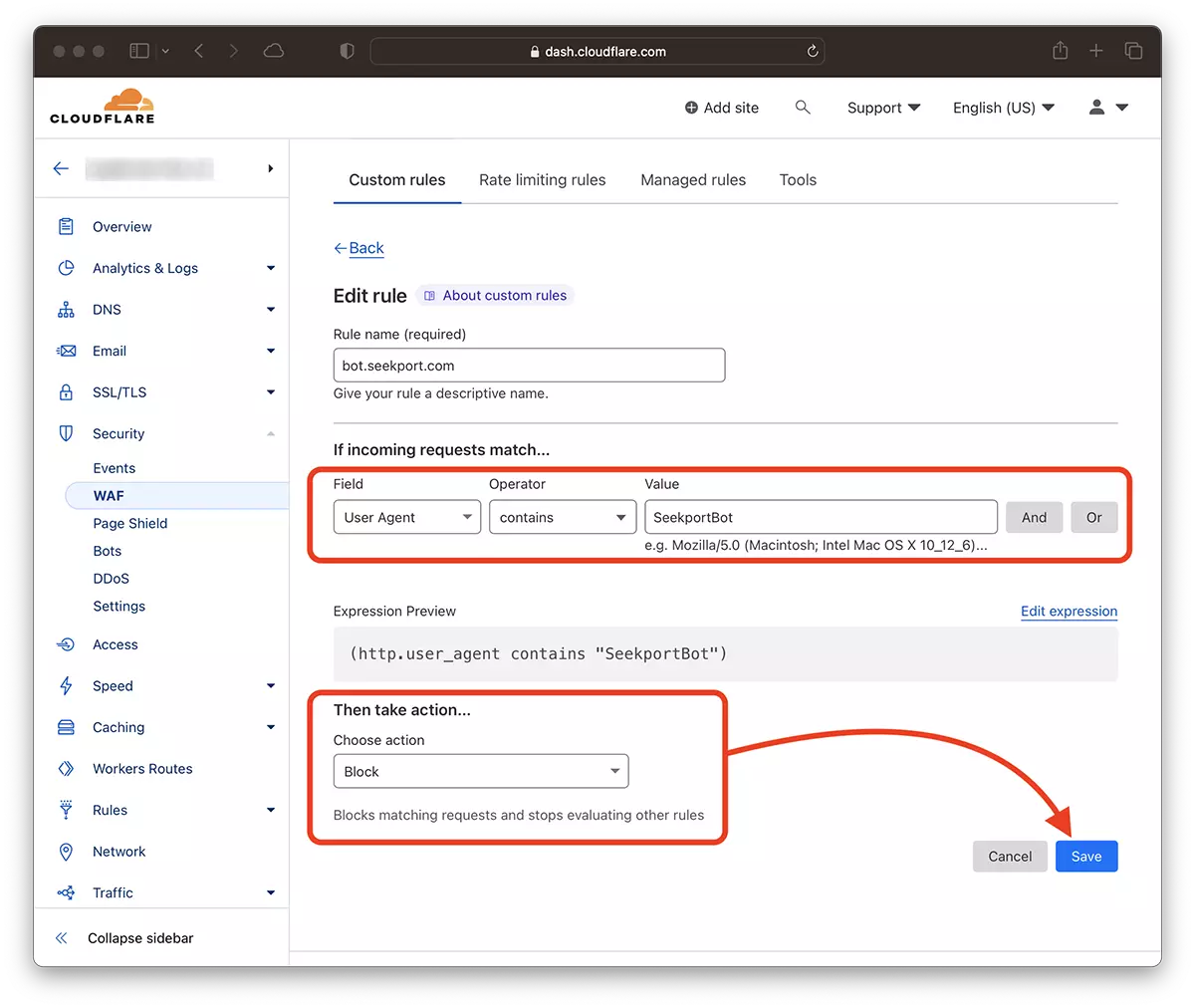

Filtrazione web crawls Con l'aiuto di CloudFlare – Blocca l'accesso a SeekportBot

Con l'aiuto di Cloudfre mi sembra il metodo più sicuro e utile con il quale puoi limitare in vari modi l'accesso ad alcuni bit a un sito Web. Il metodo che ho usato nel caso di SeekportBot per filtrare il traffico in un negozio online.

Supponendo che tu abbia già il sito Web aggiunto a CloudFore e che i servizi DNS siano attivati (cioè il traffico verso il sito è eseguito da Cloud), segui i passaggi seguenti:

1. Apri l'account Clouflare e vai al sito Web per il quale si desidera limitare l'accesso.

2. Vai a: Security → WAF e aggiungi una nuova regola. Create rule.

3. Alegi un nume pentru noua regula, Field: User Agent – Operator: Contains – Value: SeekportBot (o altro nome bot) – Choose action: Block – Deploy.

In pochi secondi la nuova regola WAF (Web Application Firewall) Comincia a fare il suo effetto.

In teoria, la frequenza con cui può essere impostato un sito di ragno per accedere a un sito robots.txt, Anche se… È solo in teoria.

User-agent: SeekportBot

Crawl-delay: 4Molti crawler Web (a parte Bing e Google) non seguono queste regole.

In conclusione, se identifichi un Web di scansione che accede eccessivamente al tuo sito, è meglio bloccare il suo accesso totale. Naturalmente, se questo bot non proviene da un motore di ricerca in cui sei interessato ad essere presente.

Come si blocca l'accesso di SeekportBot o altri robot di gattoni su un sito Web

Cosa c'è di nuovo

Di Stealth

Appassionato di tecnologia, scrivo volentieri su StealthSettings.com a partire dal 2006. Ho una vasta esperienza nei sistemi operativi: macOS, Windows e Linux, ma anche nei linguaggi di programmazione e nelle piattaforme di blogging (WordPress) e per negozi online (WooCommerce, Magento, PrestaShop).

Visualizza tutti i post di StealthPotrebbe interessarti anche...